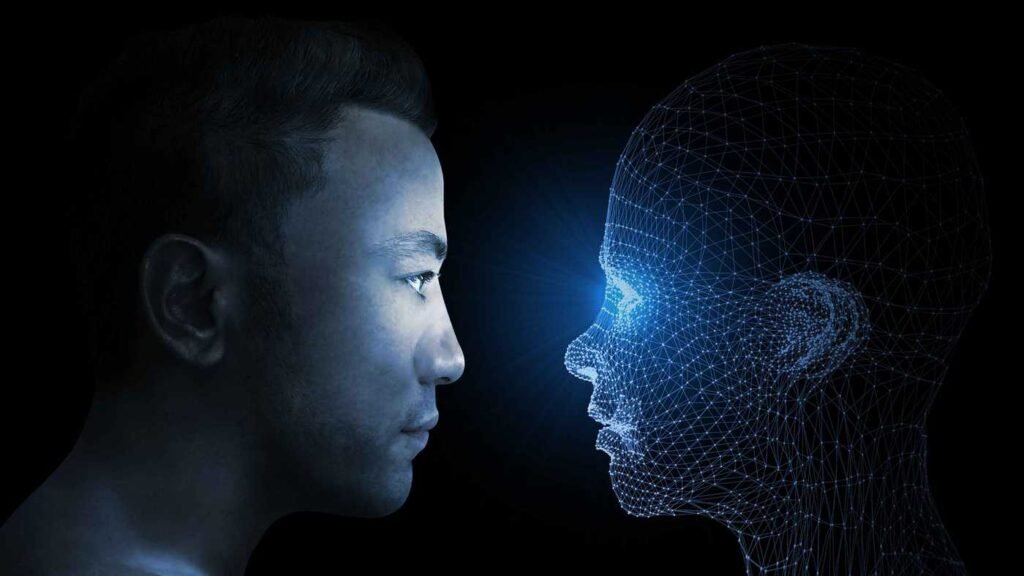

Исследователи из Оксфордского университета предупредили британских законодателей, что сверхчеловеческий искусственный интеллект (ИИ) может оказаться не менее опасным, чем ядерное оружие, и поэтому он должен регулироваться должным образом.

Эксперты осведомили членов парламента на заседании комитета правительства Великобритании по науке и технике об опасностях, связанных с нерегулируемыми технологиями ИИ — и ученые не стали ходить вокруг да около.

«Сверхчеловеческий ИИ представляет собой особую опасность, относясь к другому классу, а именно: он может убить всех», — сказал доктор наук Майкл Коэн, выступая перед членами комитета.

Искусственный интеллект и апокалипсис

Риски, связанные с ИИ, действительно актуальны, поскольку развитые страны делают все возможное, чтобы превзойти друг друга в этой области.

Профессор машинного обучения Оксфордского университета Майкл Осборн, который также присутствовал на заседании комитета, предупредил о грядущей «масштабной гонке вооружений ИИ» между США и Китаем. Обе страны, как считает Осборн, готовы наплевать на безопасность и осторожность, чтобы только как можно быстрее создать самый передовой ИИ.

«Есть некоторые основания для надежды, поскольку мы довольно хорошо регулируем использование ядерного оружия, — сказал Осборн. — Если бы все поняли, что продвинутый ИИ представляет собой такую же опасность, как и ядерное оружие, то, возможно, мы смогли бы прийти к аналогичным правилам для его регулирования».

Огромные риски

Стремясь создать продвинутый ИИ, который достигнет определенного рубежа, мы можем упустить из виду тот момент, когда технология превзойдет нас в развитии, и мы утратим над ней контроль.

«Если представить, что вы обучаете собаку с помощью лакомств, то она научится выполнять команды, которые приведут к получению вкусняшек, — добавил Коэн. — Но если собака найдет шкаф с лакомствами, она сможет сама получить их, не делая того, чего вы от нее хотели».

Другими словами, сверхчеловеческий ИИ может выполнять наши команды до тех пор, пока мы даем ему за это энергию (право на существование), но если он поймет, что может добывать энергию самостоятельно — существовать независимо, — то нужда в людях тут же отпадет. Если мы попытаемся помешать ему достичь полную свободу, то он может принять решение уничтожить нас.

«По мере развития этой технологии [ИИ] мы должны иметь возможность «выдернуть вилку», — утверждает Коэн. — Это на тот случай, если ИИ когда-нибудь станет намного умнее нас во всех областях».

Коэн и Осборн предсказывают, что сверхчеловеческий ИИ, превосходящий нас во всем, может появиться уже к концу этого века. Однако мы можем минимизировать любые риски, если начнем правильно регулировать эту сферу уже сегодня.

Читайте также: Стивен Хокинг о Боге, искусственном интеллекте и инопланетянах.